FLUX模型8倍加速,低配福音!笔记本跑出“4090级”速度?Nunchaku

这是搭载RTX 4090显卡的顶配台式机,使用当前开源AI绘图领域最先进的FLUX模型生成图片,速度约为20秒每张。

而搭载5070显卡的笔记本运行同一FLUX模型时,速度达到惊人的6秒每张,是4090显卡性能的近3倍。

它的速度之所以如此出色,是因为采用了一项创新技术。该技术可使显卡在ComfyUI中的运行速度提升至8倍,同时显著降低模型运行时的显存占用。

即使是RTX 5070这样的入门级显卡,也能流畅运行FLUX等大型模型,并且可以无缝集成到现有的工作流中。

你一定想知道Nunchaku是什么,以及如何在自己的电脑上使用它。将为你全面介绍这一工具。

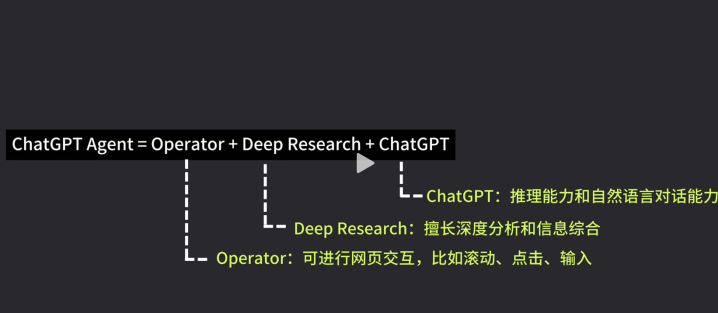

Nunchaku是今年上半年出现在ComfyUI开源社区的一个节点,由MIT HAN Lab(硬件加速神经网络实验室)与英伟达联合研发,专门针对FLUX模型进行优化。

经常使用AI工具的朋友们对FLUX模型应该非常熟悉。作为当前性能最强的开源AI绘图模型之一,FLUX拥有完善的生态支持,广泛应用于平面设计和电商宣传等领域。不过,作为本地部署的模型,其体积确实略显庞大。

在介绍FLUX模型的视频中曾提到,原版FLUX的运行门槛需要24GB显存起步,仅RTX 4090等高端显卡能够流畅运行。显存不足的设备在运行时会出现性能下降的情况。

不过,在以往的视频中我们曾提到,模型可通过量化方式降低计算负担。为此,他们提出了一种新的思维量化方法——SVD Quant,并围绕其设计了推理加速引擎Nunchaku。

Nunchaku源自日语词汇,意为双截棍,这一命名颇具特色。

从技术角度来看,这是将量化技术与推理引擎相结合的创新方案,其性能表现如同双截棍般强劲。该团队已将这项技术开源,并开发为ComfyUI的自定义节点,使得用户能够在ComfyUI平台上便捷地使用这一功能。

该技术能够显著降低显存占用,最高可将Flux模型的显存需求减少3.5倍。结合CPU Offloading技术,最低仅需4G显存即可运行Flux模型,这对低配置设备用户而言极具吸引力。对于配置较高的用户,该技术同样能大幅提升模型推理速度。

效果有多显著呢?以我的电脑测试结果为例,加速效果至少可达4-5倍。在低配置设备上,性能提升更为明显。原先需要半分钟生成一张图像,现在仅需几秒即可完成,速度已接近SD 1.5的水平。

不过需要注意的是,模型量化过程不可避免地会带来一定的质量损失。

但Nunchaku的开发者们通过配套推理引擎的设计,最大程度上降低了这一过程的损失。

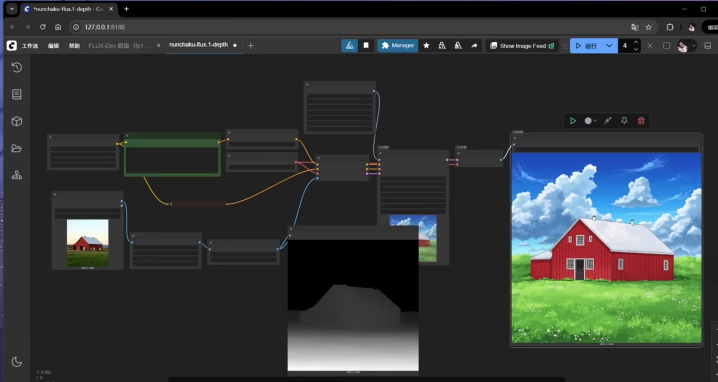

如图所示,左侧展示的是FP16原版模型的运行结果,右侧则是经过Nunchaku加速后的效果,两者的差异显而易见。

更重要的是,该加速技术具有广泛的适用性,不仅支持基础FLUX模型加速,还能无缝兼容各类FLUX LoRA模型,无需额外处理操作。同时,该技术还完整支持包括ControlNet、TileRedux等FLUX生态中的常用工具。

该工具适用于几乎所有NVIDIA显卡用户,包括最新的RTX 50系列和较老的GTX 1020系列显卡,兼容性广泛。

使用方法非常简单,只需下载模型并替换原有工作流中的1-2个节点即可生效。

看到这里,你一定想知道如何在ComfyUI中使用它。

您可以访问项目仓库以了解详细的安装流程。开发者还贴心地为用户提供了中英文双语安装视频,供您参考。部分安装步骤可能需要一定的编程基础才能更好地理解,同时这也是从头开始安装ComfyUI的过程。对于已经拥有ComfyUI的用户,我将尝试用自己的方式归纳这一过程,以供参考。

为了体验在新设备上安装该插件的过程,我使用了一台联想最新推出的设计师系列ThinkBook 16P 2025 AI原器版。该设备配备了英特尔Core Ultra 9 275HX标压处理器和英伟达GeForce RTX 5070笔记本电脑GPU,能够流畅稳定地支持各种3D建模和动态设计软件。其屏幕素质优异,可选择3.2K分辨率165Hz专业创作屏或2.5K分辨率240Hz高速动态屏,均具备500尼特高亮度和100% DCI-P3电影级色域。整机200W的性能释放可提供高达798TOPS的AI算力,轻松在本地运行Stable Diffusion等AI绘图模型来释放创意。

在本期视频介绍的Nunchaku的帮助下,该设备也能流畅运行包括FLUX在内的各种大型绘图模型,并取得出色的速度表现。稍后我们将实测其使用FLUX生成图片的速度。首先,您需要在ComfyUI中安装Nunchaku的自定义节点。

在Manager中输入ComfyUI Nunchaku进行搜索,点击安装即可。安装完成后,若直接重启,节点可能不会出现在ComfyUI中,命令行会提示导入节点失败,这是由于缺少Nunchaku推理引擎的相关依赖组件。

此时需要手动安装Nunchaku的轮子文件。轮子文件是后缀为.whl的文件,类似于压缩包,可帮助Python快速安装库和依赖项。开发者已在Github、Hugging Face和ModelScope平台提供了不同版本和型号的轮子文件供下载。

当前最新版本为0.3.0,文件名称中的字母和数字代表特定型号。安装时需根据ComfyUI所使用的PyTorch和Python版本选择对应型号的轮子文件,其中Torch表示PyTorch版本,CP表示Python版本。可在ComfyUI启动时通过命令行初始信息查看当前Python和CUDA版本。

我的Python版本为3.12,PyTorch版本为2.7.0,因此需要下载标注为Torch2.7的轮子文件。

CP312等文件。手动下载轮子文件后,右键单击并复制文件地址,随后将其安装至ComfyUI所使用的Python环境中。启动时的命令行可查询ComfyUI所使用的Python解释器目录。

打开该目录,在地址栏输入 “cmd” 并回车以启动命令行界面。随后输入指定命令,粘贴轮子文件下载地址后回车,即可将轮子文件成功安装至 ComfyUI 环境。

完成安装后重启 ComfyUI,便可在节点列表中搜索到 Nunchaku 相关节点。

距离使用Nunchaku仅剩最后一步,即将开发者制作的四位量化模型下载至ComfyUI模型库中。

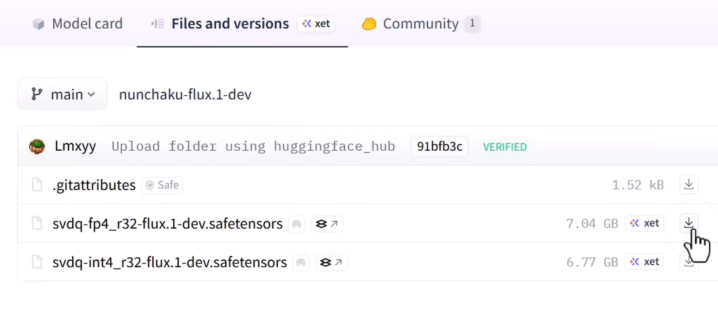

开发者已贴心地将模型上传至Hugging Face和ModelScope平台。本教程以Hugging Face为例进行演示,若访问受限,用户也可通过ModelScope获取相同资源。

平台提供了包括FluxDev、Chanel、Phil、Kenny和Devds等官方模型的量化版本。下载时可见每个模型均包含FP4和INT4两种量化格式的不同版本。

在之前的视频中,我们曾提到50系RTX GPU采用了全新的Blackwell架构,支持FP4量化精度,这将显著提升AI模型的推理性能。

由于我使用的是搭载最新RTX 5070 Laptop显卡的ThinkBook 16P,因此可以选择FP4版本的模型。若您使用的是40系或更早的设备,则需选择INT4版本的型号。

模型文件大小为数GB,下载可能需要一定时间。下载完成后,请将文件放置在根目录下的Models/Diffusion Models文件夹中即可。

完成上述操作后,您即可在ComfyUI中体验Nunchaku的运行速度。

通过搜索,你可以在节点库中找到一系列Nunchaku节点,其中最主要的三个是DiT Loader、LoRA Loader和Text Encoder Loader。它们在ComfyUI中的作用是分别替代原有的UNet加载器、LoRA加载器和CLIP加载器。

针对常规的 FLUX 工作流,只需将 UNet Loader 替换为 Nunchaku 的 FLUX DiT Loader 即可。例如,在标准的 FLUX FP16 原版工作流中,可直接将原有的 UNet 加载器和双 CLIP 加载器替换为 Nunchaku 节点。

只需添加节点并连接线路,即可构建Nunchaku加速的Flux工作流。完成节点替换后,选择已下载的对应型号模型,并启用Flux的双文本编码器,系统即可正常运行。以下展示生成速度的对比测试结果。

原Flux工作流生成一张图片耗时约20秒,而采用Nunchaku节点后仅需不到5秒即可完成,效率提升4-5倍。

这是在我的台式机上测出的速度。考虑到很多用户使用的是ThinkBook 16P这类便携笔记本,我们测试了Nunchaku在此类设备上的表现。

使用原版Flux工作流时,生成单张图片耗时超过两分钟,效率较低。

在采用Nunchaku技术后,图像生成速度得到显著提升,仅需约15秒即可完成一张图片的生成。在配备50系GPU和Nunchaku的情况下,速度提升至原先的8倍以上。

最高可配置的4TB固态硬盘进一步优化了模型加载速度。当GPU全速运行时,得益于全新的Backwell Max-Q技术和冰炫风散热模组,散热效率极高,8.012的静效指数使得散热系统几乎无感。

因此,现在可以在轻薄笔记本上流畅运行Flux模型。

在使用这些节点时,您会发现相较于常规模型加载器,界面中显示了更多参数选项。

在自定义节点的仓库中,提供了针对这些参数的详细解析。若感兴趣,可暂停阅读核心参数的说明。根据实际测试,多数情况下保持默认设置即可获得良好效果。

值得注意的是,前述节点中包含一个LoRA加载器。在使用量化FLUX模型时,可自由搭配任意LoRA,无需单独编译或调整,直接串联即可。但需使用Nunchaku的LoRA加载器进行加载。

下面进行演示:我们添加LoRA加载器,并加载吉卜力风格的LoRA模型,同时在提示词中加入相应触发词。

整个流程运行流畅,仅在加载LoRA时略有延迟。最终生成的作品成功呈现了吉卜力动漫的艺术风格。

在FLUX的应用中,部分LoRA模型能够显著提升图像生成速度,例如阿里开源的Flux Turbo。若需在工作流中添加多个LoRA模型,只需串联多个LoRA节点即可。

经实测,该工作流在笔者的设备上最快仅需3秒即可完成单张图像生成,相较FP16原版工作流实现了8倍以上的综合加速效果。

由此可见,标题所述内容真实可信。Nunchaku不仅适用于基础的文生图功能,还可应用于其他多种场景。

在下载的节点文件夹中,包含一系列官方示例工作流。如需探索更多功能,可参考这些工作流进行尝试。

例如Flux Tools中的Depth和Kenny这两个控制生成模型,我们加载对应的工作流时,它仅替换了其中的Unet加载器。导入用于控制的参考图后,填写提示词并选择量化模型,点击运行即可生成一张基于原图深度特征的新图片。

该过程速度极快且不易出错。由于本质上仅替换了工作流中的模型加载器,因此该功能不仅适用于官方工作流,还能与绝大多数Flux工作流兼容。

例如我们前几天讲解的ICEdit,其操作核心采用了Flux模型来实现重绘。

对于这一工作流,您只需将加载Fill模型的节点替换为Nunchaku,即可实现减负提速的效果。操作十分便捷。

这项技术的最大意义在于进一步扩大了Flux生态的影响力。得益于其对模型及配套设施的完善支持,许多提供在线推理服务的平台可利用其优化推理效率并节约算力。